Введение

В предыдущей части данной статьи, вы узнали о средстве, при помощи которого корпорация Microsoft позволяет рационально управлять всей инфраструктурой вашего предприятия, начиная от незначительных подразделений и групп, и заканчивая сайтами и доменами, а именно об оснастке «Управление групповой политикой». Вы узнали о том, как можно открыть данную оснастку, а также о создании, редактировании и удалении объектов групповой политики. Для правильного управления вашей организации одного лишь создания объектов GPO недостаточно, так как объект групповой политики – это только набор параметров настроек конфигурации пользователя или компьютера, которые обрабатываются расширениями клиентской стороны (Client-Side Extension - CSE). Чтобы ваши объекты GPO распространялись на клиентов, нужно настраивать связи объектов групповых политик с сайтами, доменами или подразделениями. В этой статье вы узнаете о связях объектов групповых политик.

Связывание объектов GPO

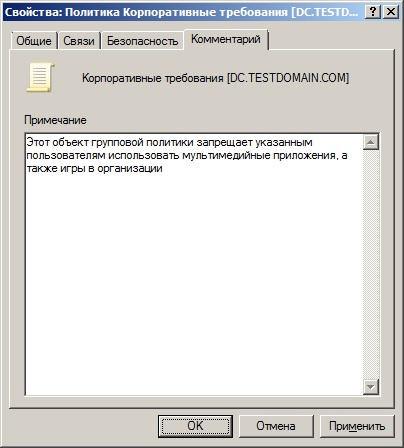

Как было указано ранее, для правильного управления клиентов, объекты групповых политик должны быть настроены на определенные параметры политик и связаны с доменом, сайтом или подразделением Active Directory. Также вы можете указать определенную группу или пользователей, предназначенных для области применения указанного GPO. Вы можете сначала создать все нужные для вас объекты GPO в контейнере «Объекты групповой политики», а потом их связать с нужными подразделениями, доменами или сайтами.

Необходимо помнить, что объект групповой политики, который связан с сайтом, влияет на все компьютеры в указанном сайте независимо от домена, которому принадлежат ваши компьютеры. В связи с этим, для того чтобы применить указанные настройки объектов групповых политик к множеству доменов в лесу, можно связать объекты GPO с сайтом. Такие объекты будут храниться на контроллерах домена. Для создания и привязки объектов групповых политик, у вашей доменной учетной записи должны быть соответствующие права. По умолчанию, за создание и управление объектов GPO отвечают только пользователи, которые входят в группы администраторов домена, администраторов предприятия и владельцев-создателей объектов групповой политики.

Для того чтобы связать существующий объект групповой политики, выполните следующие действия:

1. Откройте консоль «Управление групповой политикой»;

2. Выберите подразделение, домен или сайт, для которого будет создана связь с существующим объектом групповой политики;

3. Нажмите на нем правой кнопкой мыши и из контекстного меню выберите команду «Связать существующий объект групповой политики»;

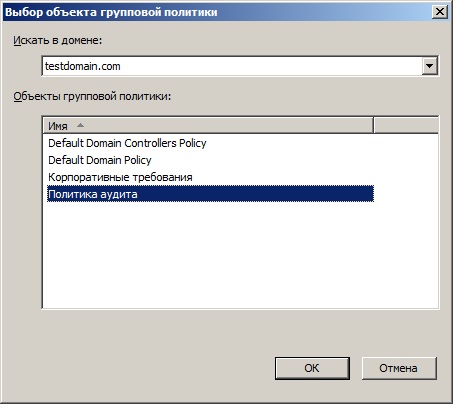

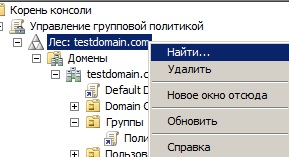

4. В диалоговом окне «Выбор объекта групповой политики» выделите объект GPO, который хотите привязать к своему подразделению и нажмите на кнопку «ОК», как показано ниже:

Рис. 1. Диалоговое окно «Выбор объекта групповой политики»

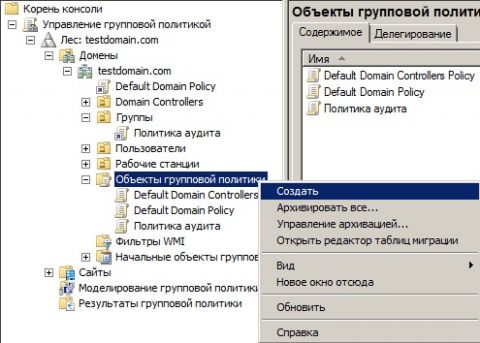

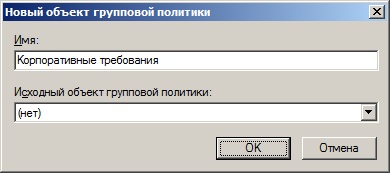

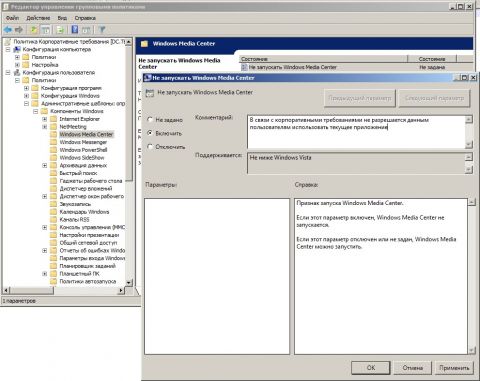

Также у вас есть возможность привязать к домену, сайту или подразделению еще не существующий объект групповой политики. В этом случае, помимо связи вам также предстоит создание нового объекта GPO. Для этого выполните следующие действия:

1. Откройте консоль «Управление групповой политикой»;

2. Выберите подразделение, домен или сайт, для которого будет создан и привязан новый объект групповых политик;

3. Нажмите на нем правой кнопкой мыши и из контекстного меню выберите команду «Создать объект групповой политики в этом домене и связать его…»;

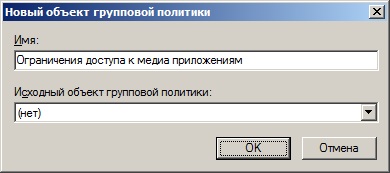

4. В диалоговом окне «Новый объект групповой политики» введите название нового объекта, например, «Ограничения доступа к медиа приложениям» и нажмите на кнопку «ОК»;

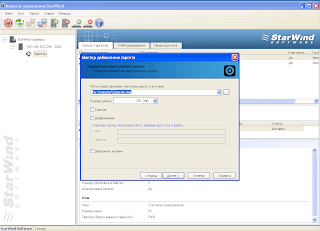

Рис. 2. Создание нового объекта групповой политики вместе со связью

5. После нажатия на кнопку «ОК» объект групповой политики будет создан вместе со связью. Для этого объекта нужно будет еще настроить определенную конфигурацию, нажав на нем правой кнопкой мыши и из контекстного меню выбрав команду «Изменить», о которой рассказывалось в предыдущей части статьи.

Один объект групповой политики вы можете одновременно связать с несколькими подразделениями, доменами или сайтами. Если вы измените конфигурацию связанного объекта групповой политики, все изменения будут применяться для указанной вами области действия GPO. Связь объекта групповой политики обозначена небольшой стрелочкой на значке объекта групповой политики. Настройки конфигурации объектов групповых политик не применяются к тем пользователям или компьютерам вашей организации, на которые не распространяется область действия объектов групповых политик. Область действия GPO – это совокупность пользователей и компьютеров, к которым применяются параметры GPO.

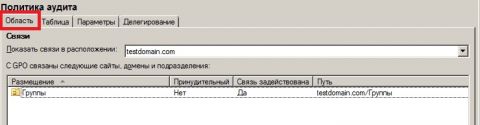

Начальная область действия объекта групповой политики назначается при привязке данного объекта к указанному контейнеру. Для того чтобы увидеть контейнеры, к которым привязан существующий объект, выберите данный объект групповой политики и перейдите на вкладку «Область», как показано на следующей иллюстрации:

Рис. 3. Область действия объекта групповой политики

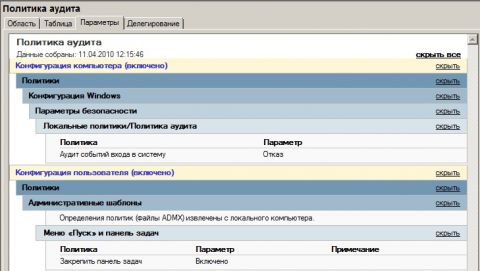

Вы можете просмотреть все измененные параметры политик для конкретного объекта групповой политики. Для этого выполните следующие действия:

1. В консоли управления групповой политикой выберите объект групповой политики;

2. Перейдите на вкладку «Параметры»;

3. В отобразившемся отчете разверните параметры политик, которые хотите просмотреть. После нажатия на ссылку «Показать все», будут отображены все измененные параметры данного объекта GPO

Рис. 4. Параметры объекта групповой политики

4. Вы можете сохранить данный отчет для дальнейшего изучения или анализа. Для этого нажмите правой кнопкой мыши на отчете и из контекстного меню выберите команду «Сохранить отчет». В диалоговом окне «Сохранение отчета объекта групповой политики» выберите папку, в которую хотите сохранить отчет, в поле «Имя файла» введите название отчета (по умолчанию название отчета совпадает с наименованием объекта GPO) и нажмите на кнопку «Сохранить». Отчет можно сохранять как с расширением HTML, так и XML.

Принудительные связи объектов групповых политик

При создании связей объектов групповых политик для некоторых контейнеров у вас могут возникнуть конфликты параметров политик. Скажем, для подразделения «Группы» у вас есть три связанных объекта GPO и в двух из них указаны разные значения одного и того же параметра политики. Например, в объекте групповой политики «Ограничение доступа к медиа приложениям» для политики «Не запускать Windows Media Center» установлено значение «Включено», а в объекте «Конфигурация конференц-зала» - наоборот, установлено значение «Отключено». В этом случае указывается параметр политики, который будет применен к клиентам при помощи приоритета объектов GPO, причем объект с более высоким уровнем приоритета будет иметь преимущество над теми объектами групповой политики, чьи приоритеты ниже.

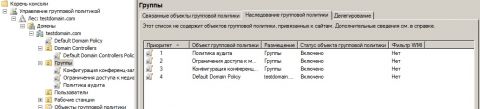

Приоритеты можно найти в консоли «Управление групповой политикой» на вкладке «Наследование групповой политики» для выбранного контейнера, как показано ниже:

Рис. 5. Наследование групповой политики

На предыдущей иллюстрации видно, что на подразделение «Группы» распространяются четыре объекта групповых политик, причем у объекта групповой политики с наименьшим значением самый высокий приоритет. Т.е., в данном случае, значения параметров политик объекта групповой политики «Политика аудита» доминирует над всеми остальными объектами GPO для данного подразделения. Но если в объекте групповой политики с наивысшим приоритетом значение для какого-либо параметра не задано, то будут применяться параметры политики с объекта групповой политики с более низким приоритетом. Наследование и делегирование групповых политик будут подробно рассмотрены в одной из следующих статей.

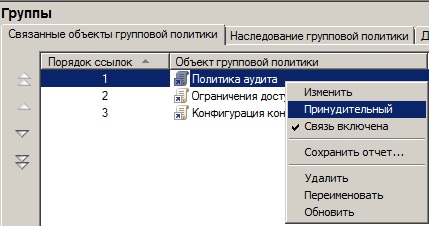

Оснастка «Управление групповой политикой» позволяет включать принудительную связь объекта групповой политики. При включении принудительной связи для объекта групповой политики, данный объект получит наивысший приоритет по отношению к остальным объектам, как выбранного контейнера, так и для всех дочерних. Для того чтобы установить принудительную связь для объекта групповой политики, выполните следующие действия:

1.Выберите контейнер, к которому привязаны несколько объектов групповых политик;

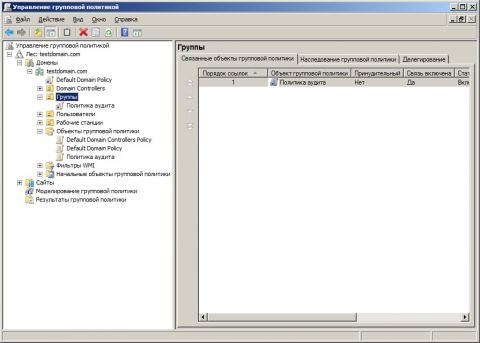

2. Перейдите на вкладку «Связанные объекты групповой политики», выберите объект, для которого хотите установить принудительную связь, нажмите на нем правой кнопкой мыши и из контекстного меню выберите команду «Принудительный»;

Рис. 6. Установка принудительной связи

3. В диалоговом окне «Управление групповой политикой» нажмите на кнопку «ОК»;

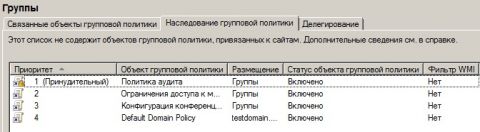

4. После установки принудительной связи, на вкладке «Связанные объекты групповой политики» для данного объекта появится значок в виде висячего замка, который обозначает принудительное включение связи. Перейдите на вкладку «Наследование групповой политики». Здесь вы можете увидеть результирующий приоритет объектов групповых политик, где в столбце «Приоритет» установленная принудительная связь будет отображаться сверху с пометкой «(Принудительный)».

Рис. 7. Принудительная связь объекта групповой политики

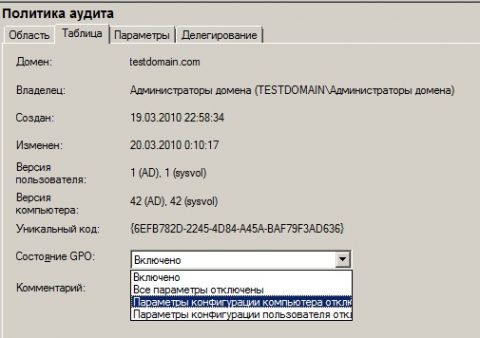

Отключение объектов групповых политик

При необходимости, для определенного объекта групповой политики вы можете запретить изменение параметров политик для узлов «Конфигурация компьютера» или «Конфигурация пользователя» средствами изменения состояния объекта GPO. Для этого выберите объект групповой политики, перейдите на вкладку «Таблица» и из раскрывающегося списка «Состояние GPO» выберите один из следующих параметров:

Рис. 8. Выбор состояния объекта групповой политики

Включено. При указании данного параметра при обновлении политик GPO обрабатываются как конфигурация компьютера, так и конфигурация пользователя. Данный параметр установлен для всех объектов групповых политик по умолчанию;

Все параметры отключены. При выборе данного параметра, объект групповой политики не будет обрабатываться;

Параметры конфигурации компьютера отключены. В этом случае, во время обновления политик GPO, будут обрабатываться только политики конфигурации пользователя. В свою очередь, параметры конфигурации компьютера будут отключены;

Параметры конфигурации пользователя отключены. В этом случае, во время обновления политик GPO, будут обрабатываться только политики конфигурации компьютера. В свою очередь, параметры конфигурации пользователя будут отключены;

Установить состояние объектов групповых политик вы можете и другим методом. Для этого разверните контейнер «Объекты групповой политики», выберите объект и нажмите на нем правой кнопкой мыши. В контекстном меню выберите команду «Состояние объекта групповой политики» и установите требуемое состояние. Но в этом случае состояние объектов групповой политики будет установлено для всех подразделений, для которых в дальнейшем будет создана связь с данным объектом GPO.

Отключение связи

Если вы случайно неправильно создали связь для объекта групповой политики, не стоит волноваться. Всегда такую связь можно удалить без нанесения ущерба самому объекту групповой политики. После удаления связи, объект GPO из контейнера «Объекты групповой политики» остается. Вы можете полностью удалить связь или отключить ее. Для удаления связи объекта групповой политики, выполните следующие действия:

1. Откройте контейнер, для которого вам нужно удалить объект GPO;

2. Выберите удаляемый объект групповой политики и нажмите на нем правой кнопкой мыши и в контекстном меню выберите команду «Удалить»;

3. В диалоговом окне «Управление групповой политикой» нажмите на кнопку «ОК».

Для того чтобы отключить объект групповой политики выберите отключаемый объект GPO и из контекстного меню снимите флажок с команды «Связь включена». После того как вы отключите связь объекта GPO, изменится и его область действия, которая больше не будет применяться для данного контейнера до тех пор, пока вы самостоятельно не включите ее. При отключении связи, значок данного объекта выглядит более прозрачным.

Заключение

В этой статье описаны методы привязки объектов групповых политик к сайтам, доменам и подразделениям вашей организации. Вы узнали о том, как можно связать существующий объект GPO с любым контейнером вашего предприятия, а также как можно создать для конкретного контейнера новый связанный объект групповой политики. Кроме того, вы ознакомились с понятием принудительных связей объектов групповых политик и научились отключать и удалять связанные объекты GPO. В следующей статье вы сможете подробно ознакомиться с понятиями наследования и делегирования объектов групповых политик.

источник

В предыдущей части данной статьи, вы узнали о средстве, при помощи которого корпорация Microsoft позволяет рационально управлять всей инфраструктурой вашего предприятия, начиная от незначительных подразделений и групп, и заканчивая сайтами и доменами, а именно об оснастке «Управление групповой политикой». Вы узнали о том, как можно открыть данную оснастку, а также о создании, редактировании и удалении объектов групповой политики. Для правильного управления вашей организации одного лишь создания объектов GPO недостаточно, так как объект групповой политики – это только набор параметров настроек конфигурации пользователя или компьютера, которые обрабатываются расширениями клиентской стороны (Client-Side Extension - CSE). Чтобы ваши объекты GPO распространялись на клиентов, нужно настраивать связи объектов групповых политик с сайтами, доменами или подразделениями. В этой статье вы узнаете о связях объектов групповых политик.

Связывание объектов GPO

Как было указано ранее, для правильного управления клиентов, объекты групповых политик должны быть настроены на определенные параметры политик и связаны с доменом, сайтом или подразделением Active Directory. Также вы можете указать определенную группу или пользователей, предназначенных для области применения указанного GPO. Вы можете сначала создать все нужные для вас объекты GPO в контейнере «Объекты групповой политики», а потом их связать с нужными подразделениями, доменами или сайтами.

Необходимо помнить, что объект групповой политики, который связан с сайтом, влияет на все компьютеры в указанном сайте независимо от домена, которому принадлежат ваши компьютеры. В связи с этим, для того чтобы применить указанные настройки объектов групповых политик к множеству доменов в лесу, можно связать объекты GPO с сайтом. Такие объекты будут храниться на контроллерах домена. Для создания и привязки объектов групповых политик, у вашей доменной учетной записи должны быть соответствующие права. По умолчанию, за создание и управление объектов GPO отвечают только пользователи, которые входят в группы администраторов домена, администраторов предприятия и владельцев-создателей объектов групповой политики.

Для того чтобы связать существующий объект групповой политики, выполните следующие действия:

1. Откройте консоль «Управление групповой политикой»;

2. Выберите подразделение, домен или сайт, для которого будет создана связь с существующим объектом групповой политики;

3. Нажмите на нем правой кнопкой мыши и из контекстного меню выберите команду «Связать существующий объект групповой политики»;

4. В диалоговом окне «Выбор объекта групповой политики» выделите объект GPO, который хотите привязать к своему подразделению и нажмите на кнопку «ОК», как показано ниже:

Рис. 1. Диалоговое окно «Выбор объекта групповой политики»

Также у вас есть возможность привязать к домену, сайту или подразделению еще не существующий объект групповой политики. В этом случае, помимо связи вам также предстоит создание нового объекта GPO. Для этого выполните следующие действия:

1. Откройте консоль «Управление групповой политикой»;

2. Выберите подразделение, домен или сайт, для которого будет создан и привязан новый объект групповых политик;

3. Нажмите на нем правой кнопкой мыши и из контекстного меню выберите команду «Создать объект групповой политики в этом домене и связать его…»;

4. В диалоговом окне «Новый объект групповой политики» введите название нового объекта, например, «Ограничения доступа к медиа приложениям» и нажмите на кнопку «ОК»;

Рис. 2. Создание нового объекта групповой политики вместе со связью

5. После нажатия на кнопку «ОК» объект групповой политики будет создан вместе со связью. Для этого объекта нужно будет еще настроить определенную конфигурацию, нажав на нем правой кнопкой мыши и из контекстного меню выбрав команду «Изменить», о которой рассказывалось в предыдущей части статьи.

Один объект групповой политики вы можете одновременно связать с несколькими подразделениями, доменами или сайтами. Если вы измените конфигурацию связанного объекта групповой политики, все изменения будут применяться для указанной вами области действия GPO. Связь объекта групповой политики обозначена небольшой стрелочкой на значке объекта групповой политики. Настройки конфигурации объектов групповых политик не применяются к тем пользователям или компьютерам вашей организации, на которые не распространяется область действия объектов групповых политик. Область действия GPO – это совокупность пользователей и компьютеров, к которым применяются параметры GPO.

Начальная область действия объекта групповой политики назначается при привязке данного объекта к указанному контейнеру. Для того чтобы увидеть контейнеры, к которым привязан существующий объект, выберите данный объект групповой политики и перейдите на вкладку «Область», как показано на следующей иллюстрации:

Рис. 3. Область действия объекта групповой политики

Вы можете просмотреть все измененные параметры политик для конкретного объекта групповой политики. Для этого выполните следующие действия:

1. В консоли управления групповой политикой выберите объект групповой политики;

2. Перейдите на вкладку «Параметры»;

3. В отобразившемся отчете разверните параметры политик, которые хотите просмотреть. После нажатия на ссылку «Показать все», будут отображены все измененные параметры данного объекта GPO

Рис. 4. Параметры объекта групповой политики

4. Вы можете сохранить данный отчет для дальнейшего изучения или анализа. Для этого нажмите правой кнопкой мыши на отчете и из контекстного меню выберите команду «Сохранить отчет». В диалоговом окне «Сохранение отчета объекта групповой политики» выберите папку, в которую хотите сохранить отчет, в поле «Имя файла» введите название отчета (по умолчанию название отчета совпадает с наименованием объекта GPO) и нажмите на кнопку «Сохранить». Отчет можно сохранять как с расширением HTML, так и XML.

Принудительные связи объектов групповых политик

При создании связей объектов групповых политик для некоторых контейнеров у вас могут возникнуть конфликты параметров политик. Скажем, для подразделения «Группы» у вас есть три связанных объекта GPO и в двух из них указаны разные значения одного и того же параметра политики. Например, в объекте групповой политики «Ограничение доступа к медиа приложениям» для политики «Не запускать Windows Media Center» установлено значение «Включено», а в объекте «Конфигурация конференц-зала» - наоборот, установлено значение «Отключено». В этом случае указывается параметр политики, который будет применен к клиентам при помощи приоритета объектов GPO, причем объект с более высоким уровнем приоритета будет иметь преимущество над теми объектами групповой политики, чьи приоритеты ниже.

Приоритеты можно найти в консоли «Управление групповой политикой» на вкладке «Наследование групповой политики» для выбранного контейнера, как показано ниже:

Рис. 5. Наследование групповой политики

На предыдущей иллюстрации видно, что на подразделение «Группы» распространяются четыре объекта групповых политик, причем у объекта групповой политики с наименьшим значением самый высокий приоритет. Т.е., в данном случае, значения параметров политик объекта групповой политики «Политика аудита» доминирует над всеми остальными объектами GPO для данного подразделения. Но если в объекте групповой политики с наивысшим приоритетом значение для какого-либо параметра не задано, то будут применяться параметры политики с объекта групповой политики с более низким приоритетом. Наследование и делегирование групповых политик будут подробно рассмотрены в одной из следующих статей.

Оснастка «Управление групповой политикой» позволяет включать принудительную связь объекта групповой политики. При включении принудительной связи для объекта групповой политики, данный объект получит наивысший приоритет по отношению к остальным объектам, как выбранного контейнера, так и для всех дочерних. Для того чтобы установить принудительную связь для объекта групповой политики, выполните следующие действия:

1.Выберите контейнер, к которому привязаны несколько объектов групповых политик;

2. Перейдите на вкладку «Связанные объекты групповой политики», выберите объект, для которого хотите установить принудительную связь, нажмите на нем правой кнопкой мыши и из контекстного меню выберите команду «Принудительный»;

Рис. 6. Установка принудительной связи

3. В диалоговом окне «Управление групповой политикой» нажмите на кнопку «ОК»;

4. После установки принудительной связи, на вкладке «Связанные объекты групповой политики» для данного объекта появится значок в виде висячего замка, который обозначает принудительное включение связи. Перейдите на вкладку «Наследование групповой политики». Здесь вы можете увидеть результирующий приоритет объектов групповых политик, где в столбце «Приоритет» установленная принудительная связь будет отображаться сверху с пометкой «(Принудительный)».

Рис. 7. Принудительная связь объекта групповой политики

Отключение объектов групповых политик

При необходимости, для определенного объекта групповой политики вы можете запретить изменение параметров политик для узлов «Конфигурация компьютера» или «Конфигурация пользователя» средствами изменения состояния объекта GPO. Для этого выберите объект групповой политики, перейдите на вкладку «Таблица» и из раскрывающегося списка «Состояние GPO» выберите один из следующих параметров:

Рис. 8. Выбор состояния объекта групповой политики

Включено. При указании данного параметра при обновлении политик GPO обрабатываются как конфигурация компьютера, так и конфигурация пользователя. Данный параметр установлен для всех объектов групповых политик по умолчанию;

Все параметры отключены. При выборе данного параметра, объект групповой политики не будет обрабатываться;

Параметры конфигурации компьютера отключены. В этом случае, во время обновления политик GPO, будут обрабатываться только политики конфигурации пользователя. В свою очередь, параметры конфигурации компьютера будут отключены;

Параметры конфигурации пользователя отключены. В этом случае, во время обновления политик GPO, будут обрабатываться только политики конфигурации компьютера. В свою очередь, параметры конфигурации пользователя будут отключены;

Установить состояние объектов групповых политик вы можете и другим методом. Для этого разверните контейнер «Объекты групповой политики», выберите объект и нажмите на нем правой кнопкой мыши. В контекстном меню выберите команду «Состояние объекта групповой политики» и установите требуемое состояние. Но в этом случае состояние объектов групповой политики будет установлено для всех подразделений, для которых в дальнейшем будет создана связь с данным объектом GPO.

Отключение связи

Если вы случайно неправильно создали связь для объекта групповой политики, не стоит волноваться. Всегда такую связь можно удалить без нанесения ущерба самому объекту групповой политики. После удаления связи, объект GPO из контейнера «Объекты групповой политики» остается. Вы можете полностью удалить связь или отключить ее. Для удаления связи объекта групповой политики, выполните следующие действия:

1. Откройте контейнер, для которого вам нужно удалить объект GPO;

2. Выберите удаляемый объект групповой политики и нажмите на нем правой кнопкой мыши и в контекстном меню выберите команду «Удалить»;

3. В диалоговом окне «Управление групповой политикой» нажмите на кнопку «ОК».

Для того чтобы отключить объект групповой политики выберите отключаемый объект GPO и из контекстного меню снимите флажок с команды «Связь включена». После того как вы отключите связь объекта GPO, изменится и его область действия, которая больше не будет применяться для данного контейнера до тех пор, пока вы самостоятельно не включите ее. При отключении связи, значок данного объекта выглядит более прозрачным.

Заключение

В этой статье описаны методы привязки объектов групповых политик к сайтам, доменам и подразделениям вашей организации. Вы узнали о том, как можно связать существующий объект GPO с любым контейнером вашего предприятия, а также как можно создать для конкретного контейнера новый связанный объект групповой политики. Кроме того, вы ознакомились с понятием принудительных связей объектов групповых политик и научились отключать и удалять связанные объекты GPO. В следующей статье вы сможете подробно ознакомиться с понятиями наследования и делегирования объектов групповых политик.

источник